深度学习算法的部署离不开轻量化的神经网络。然而,宏观的网络框架、网络模块组合方式以及微观的模块结构设计都十分耗时且需要大量专家经验,限制了相关算法在移动设备的部署。为降低设计复杂度并自动搜寻最优的网络架构,神经网络架构搜索(Neural Architecture Search,NAS)凭借其出众的任务、资源适应能力,成为了当前学术界与工业界的研究热点。

3044永利集团计算机系陈志华教授团队提出了一种基于自适应多教师蒸馏的神经网络架构搜索算法,通过利用搜索过程中多个高性能架构特征图指导搜索过程中架构重训练过程,显著降低了重训练过程需要的计算成本。同时,考虑到架构特征图之间的巨大差异,提出了一种扰动感知蒸馏策略,使最优的架构特征图更适合后续蒸馏过程。在cell和block级别的神经网络架构搜索任务和多个图像分类数据集上,该方法的性能表现都大幅优于同类方法。相关成果以“MNGNAS: Distilling Adaptive Combination of Multiple Searched Networks for One-Shot Neural ArchitectureSearch”为题被国际人工智能领域顶级期刊IEEE Transactionson Pattern Analysis and Machine Intelligence接收并线上发表,计算机视觉实验室陈志华教授为该论文的第一作者,博士生仇谷皓为该论文的第二作者(doi:10.1109/TPAMI.2023.3293885)。

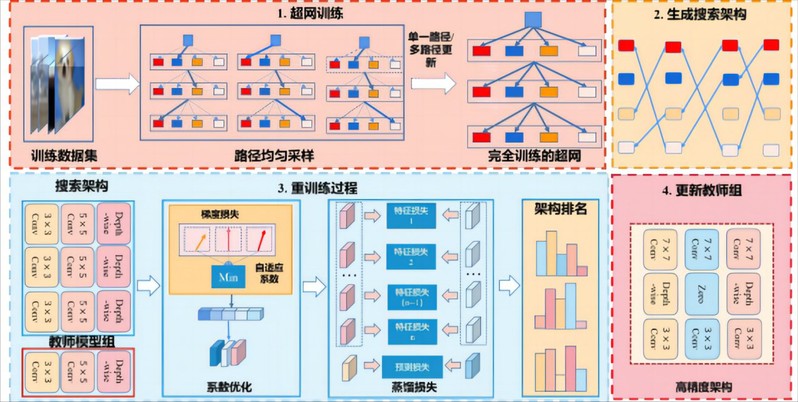

图片说明:基于自适应多教师蒸馏的神经网络搜索算法流程图

该研究指出,自适应多教师蒸馏的架构可以在较少重训练周期内获得与独立训练接近的精度排名。另外,该研究通过最优化组合系数,结合多个架构间梯度损失,有效避免了多教师蒸馏常见的妥协与过度竞争问题。

本工作得到了国家自然科学基金面上项目的支持。